推理上下文内存存储平台 (ICMSP):为何 AI 推理正逐渐成为闪存问题

随着现代 AI 系统所承载的上下文信息量远超其设计时在处理器附近所能容纳的范围,推理正遭遇一道全新的内存墙。随着 AI 从单次提示交互转向长时对话与智能体工作流,推理的内存占用正在快速扩大。这暴露了基础设施堆栈中的一个新瓶颈。

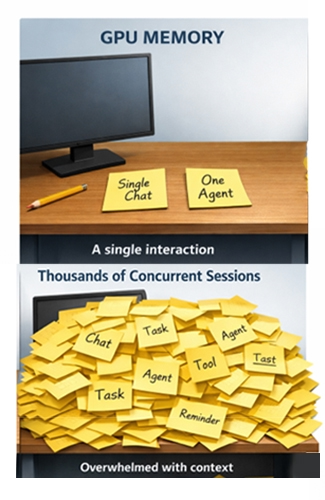

试想一下,一排 GPU 同时为数千个对话应用、智能助手和自主智能体提供服务。单次交互看似轻量,但汇聚在一起,就会形成不断增长的“工作内存”累积 - 这些信息必须被保留,才能维持连贯、高效的响应。

这些工作内存存放在键值 (KV) 缓存中,该缓存会存储先前计算出的键值对,以便在生成过程中重复使用,从而避免重复计算。1

然而,当这些上下文信息无法再容纳于最靠近 GPU 的内存层级中时,性能就会下降:时延上升、吞吐量下降,数据中心里最昂贵的硬件之一也开始出现闲置。

在 2026 年国际消费电子展 (CES 2026) 的 NVIDIA 线上活动中,NVIDIA 首席执行官黄仁勋正式推出了 NVIDIA 推理上下文内存存储平台(ICMSP,简称“ICMS”),该平台将机柜级、由闪存支持的上下文层级定位为原生适配 AI 的 KV 缓存层,可在机架规模上实现共享与复用。2、3、4

推理内存墙

在过去十年的大部分时间里,AI 基础设施的讨论焦点都集中在如何为 GPU 供给数据。随着推理负载不断演进,关注点也扩展到上下文如何随时间累积。模型能力越强,推理过程就越需要保留状态,而非直接丢弃。

KV 缓存对性能至关重要,但它会同时在多个维度上增长:

- 更长的上下文窗口会增大单会话缓存大小。

- 更高的并发性会使用户间的总内存占用成倍增加。

- 智能体工作流会延长会话生命周期,使上下文保持活跃的时间远超单次提示-响应交互。

最终结果是:推理服务在达到计算能力上限之前,往往会先达到内存容量上限。即便 GPU 仍有可用的计算周期,也可能因等待上下文读取或重新计算而停滞。这种现象在真实业务场景中尤为明显 - 尤其是对尾部延迟敏感、负载动态波动的环境。

一种常见的做法是将上下文推送到数据中心已有的共享存储系统中。然而,对于活跃的推理过程而言,这会带来新的延迟和流量挑战。传统文件系统和对象存储主要针对持久性和共享性进行优化,而非针对直接位于令牌生成关键路径上的低延迟读取操作。随着 KV 流量在网络中南北方向流动,延迟变得难以预测,拥塞加剧。

KV 缓存既需要存储级的容量,又需要内存级的响应速度。NVIDIA 的 ICMS/ICMSP 设计理念正是为了弥补这一缺口。3、4

NVIDIA 推理内存层级中的 G3.5 上下文层

NVIDIA 将推理上下文内存存储平台描述为一种完全集成的存储基础设施,它利用 NVIDIA BlueField-4 数据处理器创建一个专为特定用途设计的、在机柜层级运行的上下文内存层级,旨在弥合高速 GPU 内存与可扩展共享存储之间的差距。3、4

在 NVIDIA 的技术描述中,这一方案新增了 G3.5 层:一层专为 KV 缓存优化的以太网连接闪存层级;其设计容量足够大,可承载共享、动态变化、多轮智能体上下文;同时位置足够近,可频繁预先分阶段传回 GPU/主机内存,不会造成解码停滞。3

在实际部署中,NVIDIA 将 ICMS/ICMSP 定位为机架/机柜本地闪存层,专门为推理衍生状态(本质为临时数据)优化。上下文块可在多个服务间存储、复用与编排,无需在每个节点上独立重新生成相同的历史信息,并可在需要时向上分阶段传回。3

图 1. ICMSP - 用于活跃引用的新层级

图 1. ICMSP - 用于活跃引用的新层级

从概念上讲,这就在 GPU 高带宽内存 (HBM) 与数据湖之间创建了一个中间层级。它并非要取代现有的存储系统,而是改变了活跃推理状态的处理方式和存储位置。

推理基础设施的细分模型

了解 ICMS/ICMSP 的一种方法是将推理基础设施视为三个不同的区域:

计算节点

最靠近 GPU 的是计算节点,其将即时工作集存储在 HBM、系统内存和本地 SSD 中。这里会生成令牌,并且对延迟最为敏感。

机柜本地上下文层级

与之并行的是 ICMS/ICMSP 机柜本地上下文层。该层用于存放数据量过大、无法永久驻留在 GPU 近侧内存中,但仍需快速、可预测访问的推理状态。NVIDIA 将其描述为一个在搭配 Spectrum-X 以太网时,具备可预测、低延迟、基于远程直接内存访问 (RDMA) 特性的机柜级上下文层。3、4

数据湖

在机柜层级之外是数据湖,它依然是模型、数据集、日志和工件等持久化记录系统。这一层级至关重要,但它并非为每个令牌的响应能力而设计。ICMS/ICMSP 通过减轻将低延迟敏感的 KV 数据推入主要为持久性设计的存储基础设施的压力,从而对数据湖起到补充作用。3

支持这一模型需要的不仅仅是容量,还需要一种在机柜规模上高效管理推理上下文的方法。

图 2. GPU 机柜的 KV 缓存

图 2. GPU 机柜的 KV 缓存

数据处理器 (DPU) 在 ICMS/ICMSP 中的作用

ICMS/ICMSP 不仅仅是通过增加 SSD 容量来发挥作用,它还引入了一个用于推理上下文的专用处理层。NVIDIA 发布的资料强调,该平台由 NVIDIA BlueField-4 数据处理器驱动,并搭配 Spectrum-X 以太网,以支持基于 RDMA 的高效 KV 缓存数据访问。3、4

NVIDIA 还声称,BlueField-4 能够实现硬件加速的 KV 缓存放置,减少元数据开销和数据移动,而 Spectrum-X 以太网则作为访问 AI 原生 KV 缓存的高性能网络架构。4

总体而言,NVIDIA 所描述的这些架构选择旨在使上下文处理更靠近 GPU 且更具确定性,减少推理负载下因等待上下文而产生的停滞和耗时。

一种全新的推理内存容量规划方式

ICMS/ICMSP 最具重大意义的影响之一,是推理基础设施的容量规划方式发生了演变。推理上下文成为机架规模/机柜规模的资源,而非每个加速器附带的固定内存量。

在 NVIDIA 的技术描述中,G3.5 层级为每个 GPU 机柜提供数 PB 的共享容量,用于存储推理上下文,将存储层级扩展到 HBM/DRAM/本地 SSD 之外,同时位置仍远低于传统共享存储、延迟更低。3

这为推理引入了全新的“闪存乘数效应”。GPU 部署对机柜内部(或紧邻机柜)部署的高密度、高能效 SSD 的需求日益增长。

ICMSP 级系统的形态

早期 ICMSP 级系统在形态上接近常见的存储构建块,但用途已变。“新用途”并非组件本身,而是以接近内存的响应速度与可预测性能为推理负载提供 KV 缓存上下文服务,而非为通用应用提供文件或对象服务。3、4

- 密集的非易失性内存 (NVMe) 存储架提供了大规模池化闪存容量。

- DPU(在 NVIDIA 实现方案中为 BlueField-4)部署于这些存储池前端,负责处理上下文放置和数据移动功能。3、4

- 高带宽、低延迟以太网(NVIDIA 主推 Spectrum-X)将该层级与机柜的其他部分连接起来3、4

从硬件角度看,这是一套成熟易懂的基础设施,但角色已完全转变:它不再提供文件或对象服务,而是在负载下以稳定可预测的性能,存储并提供推理衍生上下文。

驱动对上下文内存需求的工作负载

对 ICMS/ICMSP 的需求,正是由塑造现代推理的相同工作负载所推动的。智能体系统以循环方式运行 - 观察、规划、行动和反思,其上下文保持活跃的时间远长于单个响应的时间。即便模型本身能轻松装入 GPU 内存,长上下文推理仍会使 KV 缓存不断增大。高并发部署使得尾部行为和可预测性与原始吞吐量同样重要。

在这些环境中,上下文成为首要考虑的容量因素。

ICMSP 对 SSD 需求的影响

将闪存作为上下文内存,会改变买家的优化方向。由于机柜空间有限,且上下文规模随 GPU 数量增加而增大,密度变得至关重要。能效至关重要是因为 AI 算力中心不仅受空间限制,更受功耗限制。可预测时延与服务质量也很重要,因为读取缓慢会直接导致 GPU 闲置。

耐久性也必须与上下文的行为相匹配。部分工作负载会重度复用 KV 数据,另一些则会因会话不断创建与淘汰而频繁更新。在依赖外部 KV 缓存层级的推理架构中,SSD 在真实持续负载下的表现,比峰值基准测试性能更为重要。

Solidigm 在上下文卸载时代的定位

对 Solidigm™ 而言,机架级本地上下文层级的出现印证了一个清晰趋势:随着推理变得更持久、更多轮交互,大容量闪存正不断向 GPU 侧靠近,以在规模化场景中保证上下文可访问、可预测且具备成本效益。

Solidigm 通过覆盖两大设计方向的 SSD 产品支撑这一转变。

- 时延余量紧张场景下的极致性能:Solidigm™ D7-PS1010 是一款 PCIe Gen5 SSD,专为高吞吐量与真实输入/输出场景设计。

- 单机架容量优先场景下的极致密度:Solidigm™ D5-P5336 SSD 面向超高容量(最高可达 122TB),可在有限机架空间与功耗约束下实现密度最大化。

随着需求不断成熟,SSD 的选择将取决于 KV 生命周期中重用与更新的占比,以及规模化部署下时延要求的严格程度。

价值体现:成本与功耗

NVIDIA 在其公告材料中,对 ICMS/ICMSP 给出了明确的性能与效率指标 - 例如与“传统存储”相比,每秒处理的令牌数最多可提高 5 倍,功耗效率最多可提高 5 倍(取决于基准与负载,数据来自 NVIDIA 官方声明)。2、4

实际上,上下文层级的价值体现在减少停滞、提高利用率以及在固定延迟目标下增加并发性。这些效果会直接转化为每个交付令牌的成本降低,因为 GPU 时间比存储容量昂贵得多。

整体展望

ICMS/ICMSP 指明了 AI 基础设施的发展方向:迈向机架规模系统,对计算、网络与存储围绕推理效率进行协同设计。随着推理变得更加持久且具有智能体特性,核心挑战转变为当上下文规模超出靠近 GPU 的内存容量时,系统如何优雅地处理这些上下文。

越来越多的解决方案是,在内存容量耗尽的地方部署闪存,并使其足够靠近 GPU,从而表现得如同机柜的一部分。随着这一模式普及,存储将成为决定 AI 推理成本与经济性的核心杠杆之一。

在这种环境下,存储从被动容量转变为主动型基础设施。为推理上下文选择闪存时,需要密切关注在持续的实际负载下的密度、功耗效率以及可预测的行为表现。

Solidigm 与 AI 基础设施建设方紧密合作,让闪存技术适配这些新兴需求,在推理规模不断扩展的过程中,保障推理上下文可访问、高效且具备成本效益。请访问 solidigm.com 了解更多。

关于作者

Jeff Harthorn 是 Solidigm 的 AI 数据基础设施营销分析师。Jeff 在解决方案架构、产品规划和市场营销方面拥有丰富的实践经验。他负责制定企业人工智能信息,包括液冷式 E1.S 固态硬盘的竞争研究,为我们的客户和合作伙伴将极客级细节转化为清晰的商业价值。Jeff 拥有加州州立大学萨克拉门托分校计算机工程理学学士学位。

资料来源

- NVIDIA TensorRT-LLM Docs(KV 缓存定义/行为):https://nvidia.github.io/TensorRT-LLM/latest/features/kvcache.html

- NVIDIA 博客(2026 年 1 月 5 日 CES 回顾) “NVIDIA Rubin 平台、开放模型、自动驾驶……”https://blogs.nvidia.com/blog/2026-ces-special-presentation/

- NVIDIA 技术博客(2026 年 1 月 6 日):“推出 NVIDIA BlueField-4 驱动的推理上下文内存存储平台……” https://developer.nvidia.com/blog/introducing-nvidia-bluefield-4-powered-inference-context-memory-storage-platform-for-the-next-frontier-of-ai/

- NVIDIA Newsroom/新闻稿(2026 年 1 月 5 日):“NVIDIA BlueField-4 为新一代 AI 原生存储基础设施提供动力……” https://nvidianews.nvidia.com/news/nvidia-bluefield-4-powers-new-class-of-ai-native-storage-infrastructure-for-the-next-frontier-of-ai